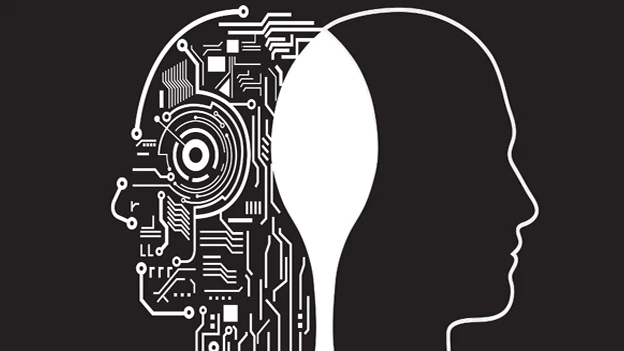

أخلاقيات التعاون بين الإنسان والآلة: ضمان العدالة والشفافية في مكان العمل

جو 24 :

يؤدي ظهور الذكاء الاصطناعي (AI) والتعلم الآلي (ML) إلى إحداث تحول سريع في مكان العمل وفي مجالات عديدة مثل منصات الاستثمار.

مع قيام الآلات بمهام أكثر تعقيدًا، يعمل البشر بشكل متعاون جنبًا إلى جنب مع الأنظمة الذكية في بيئة تعاونية.

وفي حين أن هذا التعاون بين الإنسان والآلة يوفر إمكانات هائلة للإنتاجية والابتكار، فإنه يثير أيضا أسئلة أخلاقية حاسمة حول العدالة والشفافية ومستقبل العمل في منصات التداول.

الحتمية الأخلاقية: موازنة الكفاءة مع القيم الإنسانية

يوفر دمج الذكاء الاصطناعي في مكان العمل فوائد عديدة:

●تطوير عملية صنع القرار: يمكن لخوارزميات تعلم الآلة تحليل كميات هائلة من البيانات لتحديد الأنماط والاتجاهات التي قد تفلت من انتباه الإنسان، مما يؤدي إلى اتخاذ قرارات جيدة بشكل أفضل.

●زيادة الكفاءة: يمكن للآلات أتمتة المهام المتكررة، مما يوفر الوقت والموارد البشرية للقيام بمساعي أكثر استراتيجية.

●تقليل الأخطاء البشرية: يمكن لبعض قدرات الذكاء الاصطناعي المساعدة في الحسابات والعمليات المعقدة، مما يقلل من احتمالية حدوث أخطاء.

ومع ذلك، إلى جانب هذه الفوائد هناك تحديات الأخلاقية التي تتطلب اهتمامًا دقيقًا:

●التحيز الخوارزمي: يتم تدريب خوارزميات الذكاء الاصطناعي على مجموعات البيانات التي قد تعكس التحيزات المجتمعية. وهذا يمكن أن يؤدي إلى ممارسات توظيف تمييزية، وتقييمات غير عادلة للأداء، وتخصيص متحيز للموارد.

●الشفافية في اتخاذ القرار: الطبيعة المعقدة لنماذج الذكاء الاصطناعي يمكن أن تجعل من الصعب فهم كيفية وصولها إلى القرارات. هذا النقص في الشفافية يمكن أن يؤدي إلى تآكل الثقة ويجعل من الصعب تحديد ومعالجة التحيزات المحتملة.

●العامل البشري: الاعتماد المفرط على الذكاء الاصطناعي في مهام مثل تقييم الأداء يمكن أن يقلل من قيمة الخبرة البشرية وحكمها. يعد تحقيق التوازن بين عملية صنع القرار البشرية والآلية أمرًا بالغ الأهمية.

بناء إطار أخلاقي للتعاون بين الإنسان والآلة

ولضمان مستقبل يزدهر فيه التعاون بين الإنسان والآلة، تحتاج المنظمات إلى إنشاء أطر أخلاقية. فيما يلي بعض التحديات الرئيسية:

1.العدالة في تطوير الذكاء الاصطناعي: يجب فحص مجموعات البيانات المستخدمة لتدريب نماذج الذكاء الاصطناعي بدقة لتقليل التحيز. يجب أن تشارك فرق متنوعة في تطوير وتنفيذ حلول الذكاء الاصطناعي خاصة كوننا شهدنا مؤخرا آبل تطور معالجات للذكاء الاصطناعي.

2.الذكاء الاصطناعي القابل للتفسير: ينبغي بذل الجهود لتطوير نماذج الذكاء الاصطناعي التي تتسم بالشفافية والقابلية للتفسير. يتيح ذلك للبشر فهم الأساس المنطقي وراء قرار الذكاء الاصطناعي وتحديد التحيزات المحتملة.

3.الإشراف البشري والتحكم: يجب أن يحتفظ البشر دائمًا بالسيطرة المطلقة على أنظمة الذكاء الاصطناعي. يتضمن ذلك القدرة على تجاوز قرارات الذكاء الاصطناعي وضمان التوافق مع المبادئ الأخلاقية.

4.إعادة صقل مهارات القوى العاملة وتحسين مهاراتها: نظرًا لأن الذكاء الاصطناعي يقوم بأتمتة المهام، فقد يحتاج الموظفون إلى تطوير مهارات جديدة ليظلوا على صلة بالموضوع. يجب على المؤسسات الاستثمار في برامج إعادة صقل المهارات وتحسينها لإعداد القوى العاملة لديها للمستقبل.

مستقبل تعاوني للبشر والآلات

إن التعاون بين الإنسان والآلة مهم للغاية. ومن خلال إعطاء الأولوية للاعتبارات الأخلاقية، يمكن للمؤسسات إنشاء مكان عمل يعمل فيه البشر والآلات معًا لتحقيق النتائج المثلى. وهذا المستقبل يتوقف على:

التواصل الجيد: يمكن أن يؤدي تعزيز التواصل بين البشر وأنظمة الذكاء الاصطناعي إلى بناء الثقة وضمان التوافق مع الأهداف.

التركيز على التصميم الذي يتمحور حول الإنسان: يجب تصميم أنظمة وقانون الذكاء الاصطناعي لتعزيز القدرات البشرية، وليس استبدالها.

التقييم والتحسين المستمر: يجب أن تتطور الأطر الأخلاقية المحيطة بالتعاون بين الإنسان والآلة باستمرار مع تقدم التكنولوجيا.

ومن خلال إدراك التعقيدات الأخلاقية للذكاء الاصطناعي ومعالجتها بفعالية، يمكننا أن نضمن أن التعاون بين الإنسان والآلة يبشر بعصر من التقدم والعدالة والنجاح المشترك في مكان العمل.